Monitoring der IT-Infrastruktur

Hochverfügbarkeit/Ausfallsicherheit, Security und Performance sind sicher die Qualitätsmaßstäbe für einen IT-Betrieb.

Datacenter Ausfälle - die Norm?

Hochverfügbarkeit/Ausfallsicherheit, Security und Performance sind sicher die Qualitätsmaßstäbe für einen IT-Betrieb. Das klassische IT-Tagesgeschäft sieht sich mit der Dynamik aller an sie herangetragener Anforderungen und Entwicklungen im Außen immer wieder herausgefordert.

So lassen die regelmäßigen Windows Updates gelegentlich Server-Dienste ausfallen, das Bekanntwerden von Security Lücken lassen unmittelbar neue Bedrohungen in der IT-Landschaft erkennen, Festplatten oder Serverlüfter allen chargenbedingt aus und die 10 Jahre alte Kälteanlage des Datacenters hat ein Leck und verliert Kältemittel. Das typische Normal eines geplanten IT-Arbeitstages.

Dem gegenüber steht im Allgemeinen ein IT-Betriebsteam, welches über beide Ohren in Projektthemen eingebunden ist und nun noch buchstäblich Feuer in ihrer Entstehung löschen muss, bevor hieraus ein Großbrand entsteht.

Diese Tage kennt vermutlich jeder ITler aus der Praxis, wo zumeist noch an einem Freitagnachmittag, gefühlt eine Störung die nächste jagt und dafür sorgt, dass sich das Wochenende deutlich verspätet.

Ein durchgängiges Hochverfügbarkeitskonzept verhindert bei o.g. Punkten in den meisten Fällen einen Ausfall von IT-Diensten oder dem Datacenter. Ein dringender Handlungsbedarf besteht dennoch, da man bestrebt ist den Redundanz- und Hochverfügbarkeitsstatus so schnell als möglich wiederherzustellen. Ein zweiter Fehler würde dann meist direkte Betriebsauswirkungen haben, und man möchte seine Infrastruktur und Systeme vor dem Wochenende wieder im sicheren Zustand wissen um beruhigt schlafen zu können.

Hierzu sei erwähnt, dass, rückblickend auf die letzten beiden Jahre 2020 & 2021, die Hauptursachen für Datacenterausfälle im Bereich der Versorgungsinfrastruktur zu suchen waren. So gaben im Jahr 2021 69% der befragten DC-Betreiber an, einen relevanten Ausfall gehabt zu haben, die eigenen Angaben nach zu 44% mit Image- und finanziellen Schäden einher gingen. Beachtlich ist, dass mit 43% die Stromversorgung und mit 14% die Klimatisierung, also Versorgungsinfrastruktur, primäre Gründe für Ausfälle waren.

Eine andere Umfrage aus 2020 zeigt jedoch ein Aspekt, welcher o.g. Ausfälle in deren Entstehung hätte vermeiden können. So geben hier 91% der im Jahr 2020 Befragten an, eine gravierende Störung in ihrem Datacenter gehabt zu haben, hiervon setzen jedoch nur 34% ein Monitoring mit Fernzugriff ein. Dies lässt die Annahme entstehen, dass diese Ausfälle mit einem Monitoring und Alarmmanagement auf Infrastrukturebene hätten vermieden oder zumindest im Schad- und Störungsverlauf gemindert werden können?

Quellen der Umfrage:

- Quelle LanLine Ausfallbilanz Rechenzentren 2021

- Quelle Datacenter Insider: Die Rechenzentrumsausfälle im Jahr 2020

Ebenen der Monitorings

Ebenso wie sich die Geschäftsprozesse eines Unternehmens hierarchisch auf Applikationen und darunterliegender Infrastruktur aufsetzen, so bedarf es bei einem allumfassenden Monitoring ebenso um Erfassung all dieser Ebenen.

Hierbei gilt es für diese Ebenen jeweils dem eigenen Bedarf und Anspruch entsprechende Tools zu finden, welche zudem Schnittstellen und mögliche Erfassungstools für die eingesetzte Infrastruktur bereitstellen. Hier ein Tool zu finden, dass alle Bereiche gleichermaßen abdeckt, wird bei den individuell ausgeprägten Infrastrukturen kaum möglich sein. So finden sich hier erfahrungsgemäß mehrere Tools wieder, deren Spezialisierungsschwerpunkt in einer dieser Ebenen liegt.

Herausforderungen und Mehrwerte des Monitorings

Die steigende Komplexität der Infrastruktur und in vielen IT-Operations bestehender Personalmangel führt leider häufig dazu, dass ein Monitoring nicht aktuell gehalten wird oder nur sehr oberflächlich genutzt wird. Die Mehrwerte des Monitorings werden aus dieser ungeliebten Rolle häufig noch unterschätzt. Neben der sich ergebenden Transparenz im Betrieb der Systeme folgt mit dem Aufbau und der Administration eines Monitorings zwangsläufig auch das Auseinandersetzen mit der etablierten Infrastruktur. Dahin wird dem Monitoringsystem zu einem gewissen Umfang auch die Funktion einer Dokumentation zu teil, wenn auch gleich es dieses nicht in allen Umfängen ersetzen kann, so ergänzt es vor allem Schemas mit Live und Historiendaten.

Die Frage nach dem geeigneten Tool für die ausgeprägte IT-Landschaft und den individuellen Bedarf ist essentiell und weit tragend.

In der Praxis hat sich gezeigt, dass sich vor allem Systeme, die ein offenes Schnittstellkonzept verfolgen, sich als nachhaltig und als flexible Lösung für ein Unternehmen darstellen können.

Beginnend im Bereich des Datacenter Monitorings ergeben sich aus den am Markt befindlichen Sensoren und den haustechnisch geprägten Infrastrukturanlagen bereits eine breite Anzahl an Schnittstellen, deren Datenpunkterfassung bereits die erste Hürde sein kann. So trifft man hier häufig auf klassische binäre Schaltkontakte, die Betriebs-, Warn- und Störmeldungen bereitstellen, sowie hier typische Feldbussysteme wie KNX, Modbus, BACnet.

Zudem kommen vermehrt Sensoriken, welche dem Segment IoT zuzuordnen sind, zum Einsatz. Hier findet man häufiger das bekannte SNMP Protokoll aber auch vermehrt das leichtgewichtige MQTT Protokoll oder auch OPC UA wieder.

Auf der Ebene des IT-Infrastrukturmonitorings trifft man aus einem gewissen geprägten Standard heraus die bekannten Schnittstellen SNMP, WMI, IPMI und diverse http basierende APIs wieder. Zudem bieten die Hersteller der Monitoringlösungen für die etablierten Betriebssysteme Datenerfassungstools (Agenten) an, welche die notwendigen Daten einsammeln und dem Monitoringsystem bereitstellen.

Eine Herausforderung des Datacentermonitorings, welche meist aus dem eigentlichen Datacenter Betriebskonzept entwachsen ist, liegt in den Verantwortungsbereichen der Infrastruktur. So liegt die Datacenter Infrastruktur aus ihrer Nähe zur Versorgungstechnik häufig im Verantwortungsbereich des Facility Managements. Oft kann ein durch klassische Facility Prozesse geprägtes und dahin wenig auf Datacenter Betrieb geschultes und sensibilisiertes Facility Management u.U. starke Differenzen im Anforderungsbewusstsein an einen hochverfügbaren IT-Betrieb aufweisen. Hier stellt sich die Frage, wie stark das digitale Mindset und z.B. der Einsatz von Gebäudeleittechnik und Gebäudeautomation bereits ist und kann man dieses im Prinzip ähnliche Know-How entsprechend auf das Monitoring eines Rechenzentrums adaptieren. Im Gegenzug muss man fairer Weise auch die Seite der IT beleuchten, wo es oft an dem Bewusstsein für die Versorgunginfrastruktur mangelt. In welchem der Bereiche ist dann das Monitoring eines Datacenters zu verantworten? Hochverfügbarkeit bedarf neben den technischen Voraussetzungen und Rahmenbedingungen immer auch einer Organisation und Personalkompetenz, die den Datacenterbetrieb bewerten, bedienen und verantworten kann. Im besten Fall besteht hier zwischen den Fachabteilungen kein Silodenken, sondern es existiert eine fließende Arbeits- und Verantwortungsteilung zwischen IT und Facility Management, in einem gemeinsamen Arbeitsteam Datacenter.

Was nützt ein Monitoring, welches regelmäßig Bereitschaftsdienste mit Fehlalarmen aus dem Bett klingelt?

Die Zuverlässigkeit der Daten sowie die Verarbeitung, Auswertung und ein sich anschließendes sinnhaftes Alarmmanagement sind grundlegend für die Akzeptanz eines Monitorings im Bereich aller Servicekonsumenten. So gilt es anhand einer Klassifizierung von Ereignissen abzuwägen: was sind Informationen/Hinweise, Warnungen und kritische Störungen. Es stellt sich die Frage, was kann welche Statusmeldung für einen Impact haben oder besser noch vorab die top-down gestellte Frage: Zur Abwendung welchen Schadszenarios benötige ich welche Daten von meiner Infrastruktur?

Monitoringsysteme können sehr schnell eine unübersichtliche Menge an Datenpunkten und Metriken zur Verfügung stellen, die u.U. nur Datenmüll, erhöhten Lizenzkosten und Systemressourcenbedarf erzeugen, jedoch der Statusbewertung und späteren Analyse keinen Mehrwert bieten. Hier gilt: so wenig wie möglich, so viel wie nötig.

In einer zielorientierten Betrachtung sollte man daher hierarchisch von oben nach unten die Anforderungen an das Geschäft betrachten und aus den sich ergebenden Anforderungen die notwendigen Metriken definieren, die direkt oder in logischer Verknüpfung und Abhängigkeit die gewünschte Aussage zum Status des Systems ableiten lassen. Hier ist ein holistischer Ansatz notwendig, da alle IT-gestützten Geschäftsprozesse und deren Verbindung zur IT betrachtet werden müssen.

Welche Informationen für wen?

Wie in der oben dargestellten Hierarchie gibt es für jede dieser Ebenen Monitoring Tools und Applikationen, welche sich in der Ebene spezialisiert und etabliert haben. Wenige Tools bieten ein tiefgehendes und detailliertes, ebenenübergreifendes Monitoring an. In der Praxis begegnet man hier häufig dem Konzept, dass jede Ebene durch ein eigenes Monitoring Tool überwacht wird.

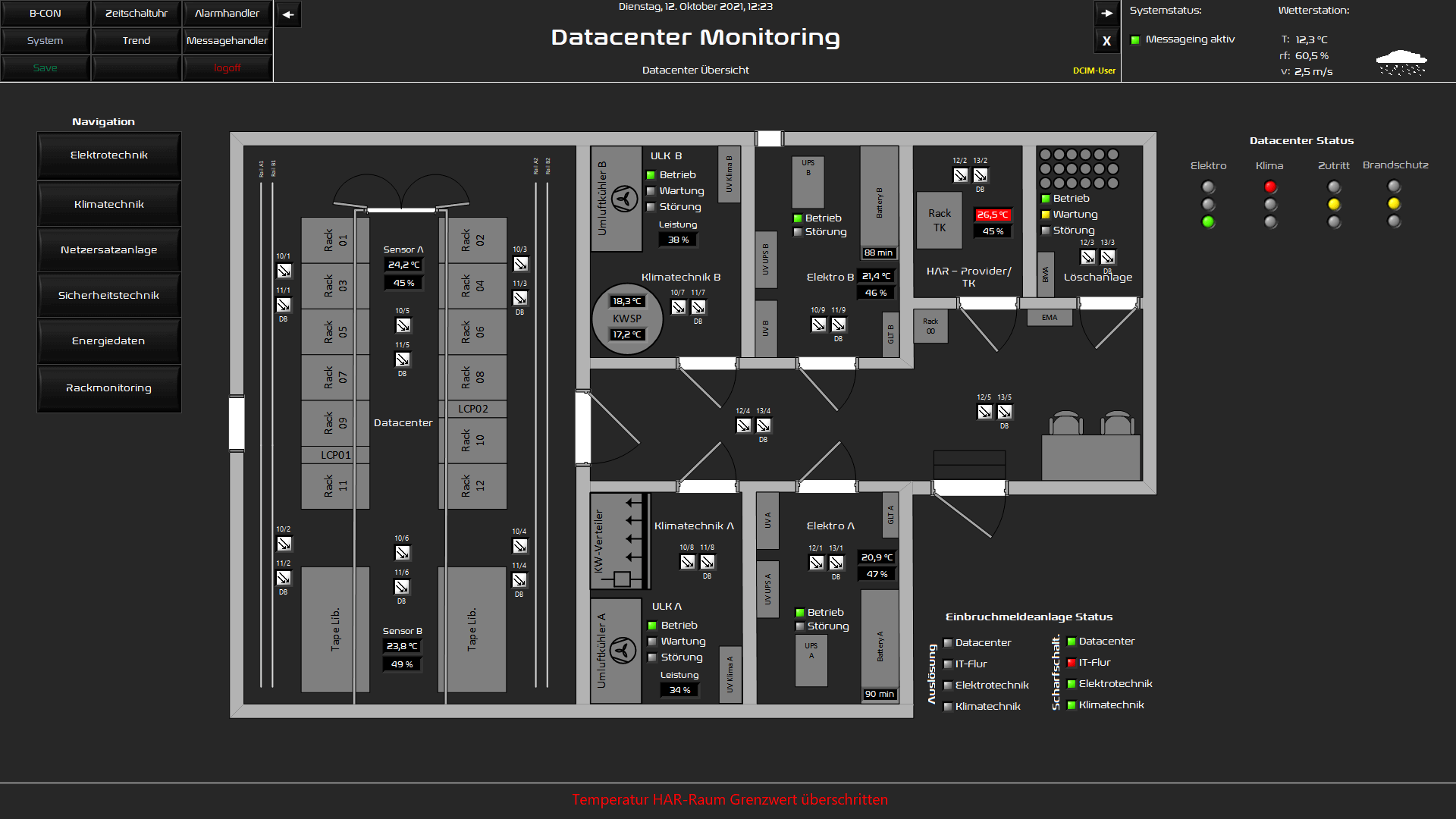

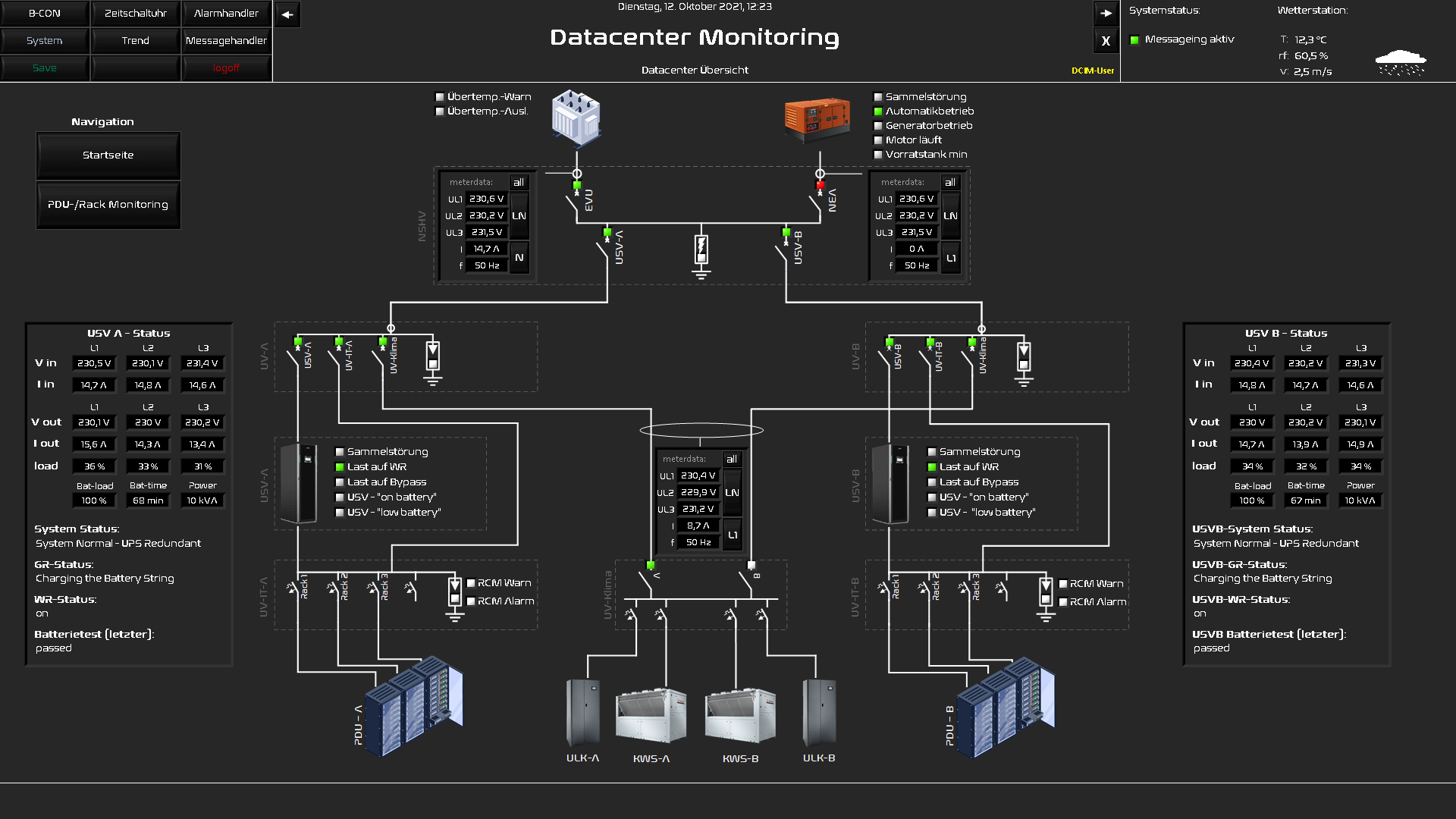

Je nach Größe der Infrastruktur und IT-Landschaft ergeben sich aus Komplexität u.U. eine große Menge an Informationen/Metriken die verarbeitet, visualisiert und bewertet werden müssen. In einem Leitstand können so alle relevanten Informationen einige großformatige Bildschirme füllen. Die dargestellten Informationen sind für die Techniker und Admins in jedem Fall hilfreich, um sich aus der Ferne schnell einen Überblick über den Zustand der Anlagen und Systeme zu verschaffen und um die Situation bewerten zu können.

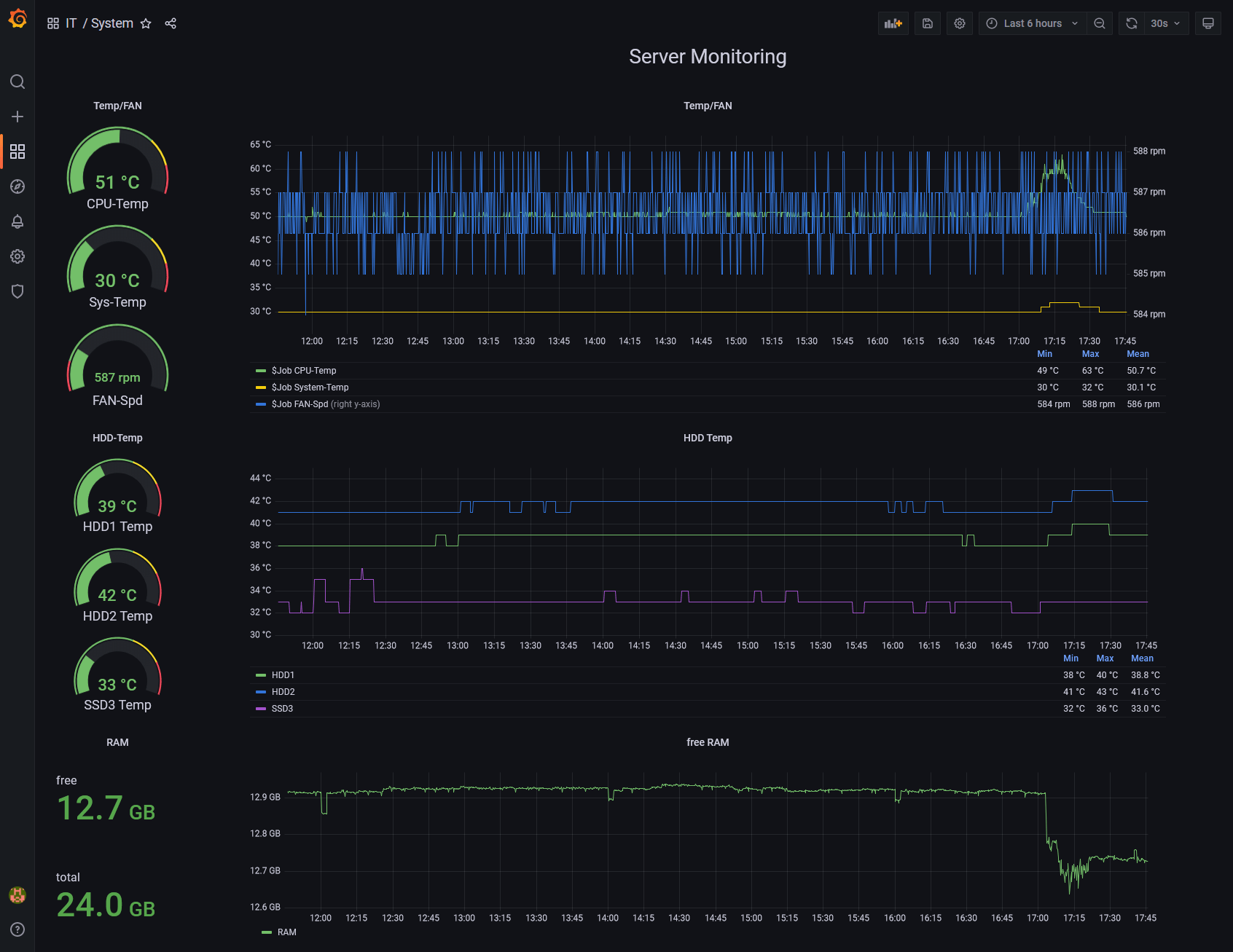

Und auch hier gibt es eine Herausforderung. Interessiert es den CIO, wie die Temperaturen oder Drücke im Kältekreis der Kälteanlagen sind, solange nicht hiervon ein aktuelles Problem ausgeht? Wenn der CIO nicht persönlich interessiert ist, wird er sich vermutlich damit nicht auseinandersetzen wollen. Daher wird sich der Fokus eines CIO´s, in Verantwortung eines sicheren und verfügbaren IT-Betriebes, bei Verfügbarkeit von Applikationen oder gar auf Prozessen befinden. Spätestens hier kommen die bekannten Schlagwörter wie Dashboard und KPI ins Spiel. Während der Techniker seine Freude im detaillierten digitalen Zwilling der Infrastruktur findet, so fühlen sich Manager in Zahlen- und Serviceorientierten Dashbords besser aufgehoben. Hierfür bietet sich u.a. das Tool Grafana, als webbasierendes Visualisierungs- und Dashboardlösung, ideal an. Für unterschiedliche Bedarfe lassen sich hier sehr anschaulich Dashboards gestalten, welche die jeweilig benötigten Informationen, egal ob KPI oder technischer Messwert, als Wertanzeige oder Graphen visualisieren.

Kosten, Aufwand und Nutzen

Was kostet mich ein Ausfall der IT-Services und was die Integration und der Betrieb eines Monitorings? Wie groß ist die Eintrittswahrscheinlichkeit und wie groß der Schaden? Welches sind die Punkte, mit denen ich bei geringen Mitteleinsatz die größte Wirkung erreiche?

Dies sind aus Geschäfts- und Wirtschaftlichkeitssicht immer die Eckpunkte, die im Rahmen eines Riskmanagements maßgeblich zur Entscheidungsfindung beitragen. Diese unternehmensspezifischen Fragen sollten zwischen Management und IT-Betrieb gestellt und diskutiert werden. In einigen Fällen ist es u.U. auch hilfreich sich objektive und erfahrene Unterstützung durch externe Beratung zukommen zu lassen.

In genauerer Betrachtung gibt es für einen einfachen Einstieg im Umfeld bereits Tools und Lösungen in etablierten und lizenzierten Produkten, welche "nur" noch konfiguriert werden müssen. So ist der SAP Solution Manager als optimales Monitoring Tool der SAP-Landschaft im SAP Business Support Vertrag bereits enthalten. Auch bieten viele Anlagen, die über moderne DDC- oder PLC-Controller geregelt werden, Möglichkeiten der Alarmierung, was in jedem Fall besser als Nichts ist, jedoch in puncto Administration und Transparenz leider sehr viele Nachteile hat.

Die gute Nachricht ist, dass es einige kostenfreie, open source Tools im Bereich Monitoring gibt. Diese basieren zwar meist auf einen Community-Support, bieten meist jedoch den vollen Funktionsumfang und können damit ein vollwertiges Monitoring bereitstellen. Supportbasierende und lizenzpflichtige Tools sind vom Hersteller supportet. Das Lizenzmodel ist meist skalierbar und die Kosten belaufen sich, im Verhältnis zur bekannten IT-Lizenzkosten, meist im überschaubaren Bereich.

Trotz überschaubarer Investitionskosten für das Tool ist die Integration, sofern die Daten nicht bereits in einer gut dokumentierten Aufbereitung vorliegen, der Teil, der die größeren Aufwände verursacht. Wenn hier in der Datacenter Infrastruktur noch notwendige Verkabelungen für Anlagenanbindungen oder Bussysteme geschaffen werden müssen, ergeben sich häufig übersehene weitere Aufwände und Kosten.

Der Gesamtaufwand ist natürlich maßgeblich vom Umfang der Visualisierung und Datenpunkte/Metriken abhängig die dargestellt, aufgezeichnet und verarbeitet werden sollen.

Man wird jedoch früh erkennen, dass die gewonnene Transparenz über Betriebszustände und das Erkennen der Anlagenverhalten, im Normal als auch im Störfall, erkennen zu können einen echten Mehrwert darstellt. In der Analyse der aufgezeichneten Trenddaten lassen sich häufig auch Defizite und Optimierungspotentiale im Betrieb der Anlagen und Systeme erkennen.

Es wundert daher nicht, dass auch die Rechenzentrumsnorm EN50600 dem Thema in ihren Unternormen Berücksichtigung geschenkt hat und Monitoring als essentielle Komponente für Hochverfügbarkeit, Energiemanagement und Absicherung eines Rechenzentrums bewertet ist.

Die Erfassung der Energieflüsse im Rechenzentrum und Auslastungen von IT-Systemen geben im Betrieb Aufschluss über ineffiziente oder gar ungenutzte Systeme die u.a. im Standby Strom verbrauchen. In Bezug auf eine verursacherbezogene Energieverbrauchsabrechnung bietet ein DCIM mit integrierten Energiemanagement sich als ein ideales Werkzeug an. Aber auch in der Notwendigkeit zum Nachweis über vereinbarte SLAs, welche der IT in ihrer Rolle als Serviceprovider unterliegen kann, kann das Monitoring als Qualitätskontroll-Tool zweckdienlich sein.

Aber Monitoring sollte nicht primär als Kosten und Energiekontrolle gesehen werden, vielmehr sollte es als das Werkzeug zur Unterstützung des täglichen IT-Betriebes eines Unternehmens sein. Im Ideal kann der Admin mit wenigen Blicken erkennen wo das Problem in der IT-Landschaft liegt oder der Techniker per Remotezugriff im Bereitschaftsdienst analysieren, ob die Netzstörung ein sofortiges Handeln nötig macht oder nur eine „Netzschwankung“ im öffentlichen Versorgungsnetz war.

Hieraus ergibt sich für das Monitoring als zentrales Werkzeug besonders im Katastrophenfall eine besondere Bedeutung. Unserer Meinung nach sollte das Monitoring das letzte System sein, bei welchem die „Lichter“ ausgehen. Das System mit Alarmierung sollte selbst im Katastrophenfall bis zum Schluss zuverlässig den Status des Datacenters anzeigen können, um den Krisenmanagement zweckdienliche Informationen bereitzustellen.

In technischer Umsetzung sehen wir dahin das Monitoringsystem nicht als virtualisierten Server und mit autarken Netzwerkkomponenten, die u.U. auch eine eigene Verkabelung bis zum SMS-Gateway bereitstellen.

Ist die Stromversorgung des Rechenzentrums mit zwei Versorgungspfaden aufgebaut, sollte auch das Monitoring diesem redundanten A-B Versorgungskonzept folgen und Monitoring-Hardware ebenso logisch auf dieses A-B Versorgungskonzept aufgeteilt werden.

Basis für Automatisierung

Hieraus ergibt sich für das Monitoring als zentrales Werkzeug besonders im Katastrophenfall eine besondere Bedeutung. Unserer Meinung nach sollte das Monitoring das letzte System sein, bei welchem die „Lichter“ ausgehen. Das System mit Alarmierung sollte selbst im Katastrophenfall bis zum Schluss zuverlässig den Status des Datacenters anzeigen können, um den Krisenmanagement zweckdienliche Informationen bereitzustellen.

Fazit

Wer hochverfügbare und komplexe IT-Landschaften effizient und sicher betreiben möchte, kommt an einem Monitoring nicht mehr vorbei. Eine Standardlösung wird es als Paket ebenso wenig geben wie eine IT-Landschaft für ihr Unternehmen. Die Möglichkeiten und Anforderungen sind so individuell wie jedes Unternehmen. Jede Infrastrukturkomponente und jeder Standard prägen dahin die Anforderungen und Schnittstellen, die ein Monitoring haben sollte. Die Organisationsstruktur um den IT- Betrieb ist neben der Technik die Komponente welche maßgeblich Auswirkungen auf Alarmierung und Visualisierung haben dürfte.

Da ein Monitoring in der Implementierung mit der gesamten Infrastruktur und den IT-Systemen verwächst, sollte man vor einer ambitionierten Einführung eines Systems die Fragen zu den eigenen Anforderungen, Alarmierungsszenarien und den Umfang der Systeme, die gemonitort werden sollen, bewusst stellen.

Der Aufbau eines Monitorings, welches erst einmal den größten Aufwand darstellt, folgt dann der Betrieb und die Pflege des Systems. Hier muss man sich auch im Klaren sein, dass es hier immer wieder Anpassungen und ein regelmäßiges House Keeping geben muss. Aber auch das disziplinierte in Wartung setzen von Metriken oder Systemen, die im Rahmen von Umbauten, Wartungen Alarme auslösen würden, ist dann notwendig und wichtig die Akzeptanz des Systems aufrecht zu erhalten. Wenn ein Monitoringsystem leider erst einmal den Status eines nervigen Fehlalarmsystems erreicht hat, sinkt dessen Akzeptanz und Nutzen.

Kontaktieren Sie uns!

Wir freuen uns darauf Sie kennenzulernen

Gerne nehmen wir uns gemeinsam auch Ihrer IT an und entwickeln strategische Grundsätze, entwerfen verlässliche Systemarchitekturen, implementieren eine fundierte Basis und sorgen für eine modulare, skalierbare und hochverfügbare IT in Ihrem Unternehmen – auch abseits von SAP. Rufen Sie uns an oder schreiben uns eine E-Mail: Wir sind gespannt, was wir zusammen erreichen können!